Выбор статистической модели

Выбор модели — это задача выбора статистической модели из набора моделей-кандидатов по имеющимся данным. В простейшем случае рассматривается существующий набор данных. Однако задача может вовлекать планирование экспериментов, так что сбор данных связан с задачей выбора модели. Если заданы кандидаты в модели с одинаковой силой предсказания или объяснения, наиболее простая модель скорее всего будет лучшим выбором (бритва Оккама).

Кониси и Китагава[1] утверждают: «Большинство задач при статистическом выводе можно считать задачами, связанными со статистическим моделированием». Вместе с тем, Кокс[2] сказал: «Каким образом осуществлена трансляция от предметной задачи к статистической модели является наиболее критической частью анализа».

Выбор модели может также относиться к задаче выбора нескольких представляющих моделей из большого набора вычислительных моделей с целью принятия решения или оптимизации в условиях неопределённости.

Введение

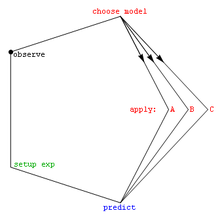

В наиболее простых формах выбор модели является одной из фундаментальных задач научного поиска. Определение принципа, который объясняет ряд наблюдений, часто связан напрямую с математической моделью предсказания этих наблюдений. Например, когда Галилей осуществлял свои эксперименты с наклонной плоскостью, он демонстрировал, что движение шара идёт по параболе, предсказанной в его модели.

При бесконечном числе возможных механизмов и процессов, которые могут дать данные, как можно даже подступить к выбору лучшей модели? Математический подход обычно принимает решение среди набора кандидатов в модели. Этот набор должен быть выбран исследователем. Часто используются простые модели, такие как многочлены, по меньшей мере в начале. Бёрнем и Андерсен[3] подчёркивают в своей книге важность выбора моделей на основе научных принципов, таких как понимание феноменологических процессов или механизмов (например, химических реакций) для данных.

Когда множество кандидатов в модели выбрано, статистический анализ позволяет выбрать лучшую из этих моделей. Что означает слово лучшая, вопрос дискуссионный. Техника выбора хорошей модели будет балансировать между адекватностью модели и простотой. Более сложные модели способны лучше адаптироваться к данным (например, многочлен пятой степени может в точности представлять шесть точек), однако дополнительные параметры могут не представлять ничего полезного (возможно, эти шесть точек на самом деле случайным образом распределены вдоль прямой). Адекватность модели обычно определяется с помощью отношения правдоподобия или приближения к нему, что приводит к критерию хи-квадрат. Сложность в общем случае измеряется подсчётом числа параметров модели.

Техники выбора модели можно считать оценками некоторых физических величин, таких как вероятность того, что модель даст имеющиеся данные. Смещение и дисперсия являются важными показателями качества предсказателя. Часто рассматривается также показатель эффективности.

Стандартным примером выбора модели служит подбор кривой, где, по заданному набору точек и другим сведениям общего характера (например, когда точки являются результатом выборки независимых случайных величин), мы должны выбрать кривую, которая описывает функцию, генерирующую точки.

Методы для выбора множества кандидатов в модели

Критерии

Если заранее ограничиваться рассмотрением только моделей авторегрессии (AR), то есть полагать, что процесс Xt следует модели AR(k) с неизвестным истинным порядком k, то для определения k в таких ситуациях долгое время использовался[4]

- Информационный критерий Акаике (AIC), мера адекватности статистической модели. Впоследствии было выяснено, что оценка Акаике несостоятельна и асимптотически переоценивает (завышает) истинное значение k0 с ненулевой вероятностью[4].

Более предпочтительным является часто используемый в настоящее время[4]

- Байесовский информационный критерий (BIC), известный также как информационный критерий Шварца, статистический критерий выбора модели.

Несколько позднее был предложен[4]

- Информационный критерий Хеннана – Куинна[англ.], обладающий более быстрой сходимостью к истинному значению k0 при . Однако при небольших значениях T этот критерий недооценивает порядок авторегрессии.

Часто используется

Используются также следующие критерии

- Перекрёстная проверка

- Информационный критерий отклонения[англ.] (DIC), ещё один байесовский критерий выбора модели

- Критерий эффективности опознавания (англ. Efficient determination criterion, EDC)

- Уровень ложноположительных результатов[англ.]

- Сфокусированный информационный критерий[англ.] (FIC), критерий выбора статистических моделей по их эффективности для заданного параметра

- Тест отношения правдоподобия, статистический тест, используемый для проверки ограничений на параметры статистических моделей, оцененных на основе выборочных данных.

- Статистика Cp Мэллоуса[англ.]. Считается, что для хорошей модели эта статистика должна принимать значения, близкие к числу параметров модели (включая свободный член)[5].

- Принцип минимальной длины описания (Алгоритмическая теория информации) — это формализация бритвы Оккама, в которой лучшая гипотеза (модель и её параметры) для данного набора данных это та, которая ведёт к лучшему сжиманию данных.

- Сообщение минимальной длины (Алгоритмическая теория информации)

- Структурная минимизация риска[англ.]

- Ступенчатая регрессия[англ.]. Цель пошаговой регрессии состоит в отборе из большого количества предикатов небольшой подгруппы переменных, которые вносят наибольший вклад в вариацию зависимой переменной.

- Информационный критерий Ватанабе — Акаике[англ.] (WAIC), информационный критерий широкого применения

См. также

- Все модели неправильны[англ.]

- Анализ конкурирующих гипотез[англ.]

- Автоматическое машинное обучение

- Дилемма смещения–дисперсии

- Парадокс Фридмана[англ.]

- Поиск по сетке параметров

- Анализ идентифицируемости[англ.]

- Логарифмический линейный анализ[англ.]

- Идентификация систем

- Бритва Оккама

- Оптимальный план эксперимента[англ.]

- Задача выбора параметра[англ.]

- Обоснование регрессионной модели[англ.]

- Моделирование

- Парадокс Штайна[англ.]

Примечания

- ↑ Konishi, Kitagawa, 2008, с. 75.

- ↑ Cox, 2006, с. 197.

- ↑ Burnham, Anderson, 2002.

- ↑ 1 2 3 4 Информационные критерии. Дата обращения: 30 декабря 2018. Архивировано 14 апреля 2018 года.

- ↑ Mallows, 1973, с. 661—675.

Литература

- Mallows C. L. Some Comments on CP // Technometrics. — 1973. — Т. 15, вып. 4. — doi:10.2307/1267380.

- Aho K., Derryberry D., Peterson T. Model selection for ecologists: the worldviews of AIC and BIC // Ecology. — 2014. — Т. 95. — С. 631–636. — doi:10.1890/13-1452.1.

- Anderson D.R. Model Based Inference in the Life Sciences. — Springer, 2008.

- Ando T. Bayesian Model Selection and Statistical Modeling. — CRC Press, 2010.

- Leo Breiman. Statistical modeling: the two cultures // Statistical Science. — 2001. — Т. 16. — С. 199–231. — doi:10.1214/ss/1009213726.

- Burnham K.P., Anderson D.R. Model Selection and Multimodel Inference: A Practical Information-Theoretic Approach. — 2nd. — Springer-Verlag, 2002. — ISBN 0-387-95364-7. [книга цитируется более 38000 раз на Google Scholar]

- Chamberlin T.C. The method of multiple working hypotheses // Science. — 1890. — Т. 15. — С. 93. — doi:10.1126/science.ns-15.366.92. — . (Перепечатано в 1965, Science 148: 754—759 [1] doi:10.1126/science.148.3671.754)

- Gerda Claeskens. Statistical model choice // Annual Review of Statistics and Its Application. — 2016. — Т. 3. — С. 233–256. — doi:10.1146/annurev-statistics-041715-033413. — . (недоступная ссылка)

- Claeskens G., Hjort N.L. Model Selection and Model Averaging. — Cambridge University Press, 2008. — (CAMBRIDGE SERIES IN STATISTICAL AND PROBABILISTIC MATHEMATICS). — ISBN 978-0-521-85225-8.

- Principles of Statistical Inference. — Cambridge University Press, 2006. — ISBN 0-511-34858-4.

- Konishi S., Kitagawa G. Information Criteria and Statistical Modeling. — Springer, 2008. — ISBN 978-0-387-71886-6.

- Model Selection / Lahiri P.. — Beachwood, Ohio: Institute of Mathematical Statistics, 2001. — Т. 38. — (LECTURE NOTES-MONOGRAPH SERIES). — ISBN 0-940600-52-8.

- Leeb H., Pötscher B. M. Model selection // Handbook of Financial Time Series / Torben G. Andersen, Richard A. Davis, Jens-Peter Kreiß, Thomas Mikosch. — Springer, 2009. — С. 889–925. — ISBN 978-3-540-71296-1. — doi:10.1007/978-3-540-71297-8_39.

- Lukacs P. M., Thompson W. L., Kendall W. L., Gould W. R., Doherty P. F. Jr., Burnham K. P., Anderson D. R. Concerns regarding a call for pluralism of information theory and hypothesis testing // Journal of Applied Ecology. — 2007. — Т. 44, вып. 2. — С. 456–460. — doi:10.1111/j.1365-2664.2006.01267.x.

- Allan D. R. McQuarrie, Chih-Ling Tsai. Regression and Time Series Model Selection. — Singapore: World Scientific, 1998. — ISBN 981-02-3242-X.

- Massart P. Concentration Inequalities and Model Selection / Editor: Jean Picard. — Springer, 2007. — Т. 1896. — (Lecture Notes in Mathematics). — ISBN 3-540-48497-3.

- Massart P. A non-asymptotic walk in probability and statistics // Past, Present, and Future of Statistical Science. — Chapman & Hall, 2014. — С. 309—321.

- Paulo Angelo Alves Resende, Chang Chung Yu Dorea. Model identification using the Efficient Determination Criterion // Journal of Multivariate Analysis. — 2016. — Т. 150. — С. 229–244. — doi:10.1016/j.jmva.2016.06.002.

- Shmueli G. To explain or to predict? // Statistical Science. — 2010. — Т. 25. — С. 289–310. — doi:10.1214/10-STS330. — arXiv:1101.0891.

- Wit E., van den Heuvel E., Romeijn J.-W. ‘All models are wrong...’: an introduction to model uncertainty // Statistica Neerlandica. — 2012. — Т. 66. — С. 217–236. — doi:10.1111/j.1467-9574.2012.00530.x.

- Wit E., McCullagh P. The extendibility of statistical models // Algebraic Methods in Statistics and Probability / M. A. G. Viana, D. St. P. Richards. — 2001. — С. 327—340.

- Anna Wójtowicz, Tomasz Bigaj. Justification, confirmation, and the problem of mutually exclusive hypotheses // Uncovering Facts and Values / Adrian Kuźniar, Joanna Odrowąż-Sypniewska. — Brill Publishers, 2016. — С. 122–143. — doi:10.1163/9789004312654_009.