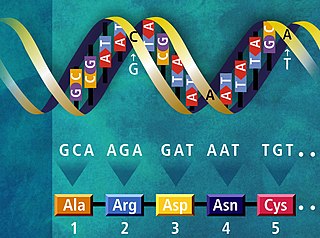

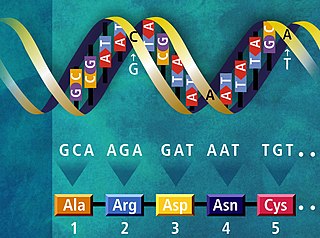

Информа́ция — сведения независимо от формы их представления.

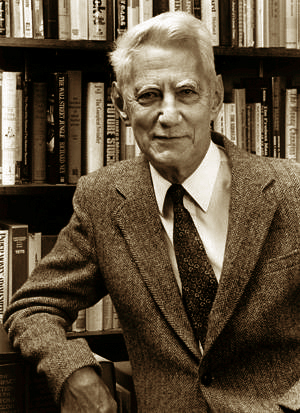

Клод Э́лвуд Ше́ннон — американский инженер, криптоаналитик и математик. Считается «отцом информационного века».

Контроль ошибок — комплекс методов обнаружения и исправления ошибок в данных при их записи и воспроизведении или передаче по линиям связи.

Теория информации — раздел прикладной математики, радиотехники и информатики, относящийся к измерению количества информации, её свойств и устанавливающий предельные соотношения для систем передачи данных. Как и любая математическая теория, теория оперирует математическими моделями, а не реальными физическими объектами. Использует, главным образом, математический аппарат теории вероятностей и математической статистики.

Институт инженеров электротехники и электроники — IEEE — некоммерческая инженерная ассоциация из США, разрабатывающая широко применяемые в мире стандарты по радиоэлектронике, электротехнике и аппаратному обеспечению вычислительных систем и сетей. Корпоративный офис находится в Нью-Йорке, а центр операций в Пискатауэе (Нью-Джерси). Образован в 1963 году путём объединения Американского института инженеров-электриков и Института радиоинженеров. По состоянию на 2018 год это крупнейшая в мире ассоциация технических специалистов, насчитывающая более 423 000 членов в более чем 160 странах мира. Целями Института являются образовательный и технический прогресс в области электроники и электротехники, телекоммуникаций, вычислительной техники и смежных дисциплин.

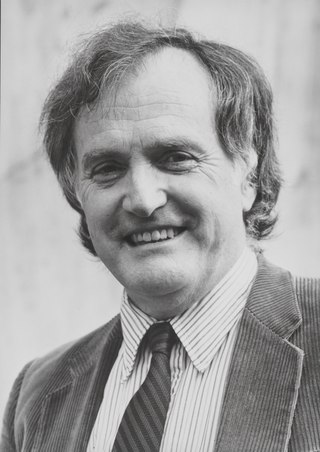

Дэ́вид Ха́ффман — американский учёный, первопроходец в сфере теории информации, преподаватель.

Хронология событий, связанных с  теорией информации,

теорией информации, сжатием данных,

сжатием данных,  кодами коррекции ошибок и смежных дисциплин:

кодами коррекции ошибок и смежных дисциплин:

- 1872

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа.

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа. - 1878

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы.

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы. - 1924

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации.

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации. - 1927

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике.

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике. - 1928

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой.

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой. - 1929

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы.

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы. - 1940

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus.

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus. - 1944

— теория информации Клода Шеннона в основном завершена.

— теория информации Клода Шеннона в основном завершена. - 1947

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года.

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года. - 1948

— Клод Шеннон публикует Математическую теорию связи

— Клод Шеннон публикует Математическую теорию связи - 1949

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли.

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли. - 1949

— Рассекречена Теория связи в секретных системах Клода Шеннона.

— Рассекречена Теория связи в секретных системах Клода Шеннона. - 1949

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано.

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано. - 1949

— опубликовано Неравенство Крафта — Макмиллана.

— опубликовано Неравенство Крафта — Макмиллана. - 1949

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения.

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения. - 1950

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения.

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения. - 1951

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера.

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера. - 1951

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь.

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь. - 1953

— опубликован Sardinas–Patterson algorithm.

— опубликован Sardinas–Patterson algorithm. - 1954

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера.

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера. - 1955

— Питер Элиас вводит свёрточные коды.

— Питер Элиас вводит свёрточные коды. - 1957

— Юджин Прандж первый обсуждает циклический избыточный код.

— Юджин Прандж первый обсуждает циклический избыточный код. - 1959

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды).

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды). - 1960

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона.

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона. - 1962

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений.

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений. - 1966

— опубликована статья Дэвида Форнея Concatenated error correction code.

— опубликована статья Дэвида Форнея Concatenated error correction code. - 1967

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов.

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов. - 1968

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году.

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году. - 1968

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод.

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод. - 1972

— опубликована статья о Justesen code.

— опубликована статья о Justesen code. - 1973

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования.

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования. - 1976

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции.

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции. - 1976

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM.

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM. - 1977

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77)

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77) - 1982

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек.

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек. - 1989

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь.

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь. - 1993

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов.

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов. - 1994

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2.

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2. - 1995

— Benjamin Schumacher предложил термин Кубит.

— Benjamin Schumacher предложил термин Кубит. - 1998

— предложен Fountain code.

— предложен Fountain code. - 2001

— описан алгоритм Statistical Lempel–Ziv.

— описан алгоритм Statistical Lempel–Ziv. - 2008

— Erdal Arıkan предложил Полярные коды.

— Erdal Arıkan предложил Полярные коды.

Джеймс Ли Мэ́сси — американский учёный, внесший значительный вклад в теорию информации и криптографию. Являлся профессором-эмеритом цифровых технологий в Швейцарской высшей технической школе Цюриха. Наиболее значительными его работами являются применение алгоритма Элвина Берлекэмпа поиска кратчайшего регистра сдвига с линейной обратной связью к линейным кодам, разработка блочных алгоритмов шифрования IDEA и SAFER, криптосистема Мэсси-Омуры.

Энтропия языка — статистическая функция текста на определённом языке либо самого языка, определяющая количество информации на единицу текста.

«Математическая теория связи» — статья, опубликованная Клодом Шенноном в 1948 году в реферативном журнале американской телефонной компании «Bell System» и сделавшая его всемирно известным. Содержит в себе большое количество инновационных и плодотворных идей, эта работа инициировала многие научные исследования по всему миру, продолжающиеся по сей день, положив начало развитию методов обработки, передачи и хранения информации.

«Теория связи в секретных системах» — статья американского математика и инженера Клода Шеннона, опубликованная в журнале Bell System Technical Journal в 1949 году.

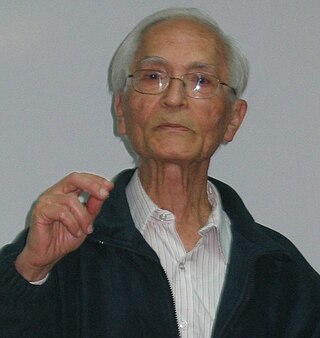

Александр Семёнович Хо́лево — советский и российский математик, специалист в области математических проблем квантовой информатики, академик РАН.

Премия Морриса Либманна — награда, которая вручалась Институтом радиотехников и позднее Институтом инженеров электротехники и электроники (IEEE) за важный вклад в радиосвязь. Награда учреждена в 1919 году, и изначально называлась Премией Морриса Либманна Института радиоинженеров. Получила своё современное название в 1963 году, когда Институт радиоинженеров слился с Американским институтом электротехников. При этом область награды изменилась - с 1964 года её присуждали за новые технологии. Упразднена в 2000 году, с 2001 года за новые технологии вручается Премия Дэниэла Нобла.

Яаков Зив или Якоб Зив — израильский учёный-математик, специалист в области теории информации и теории кодирования.

Элвин Берлекэмп — американский математик, заслуженный профессор математики, электротехники и компьютерных наук в Университете Калифорнии в Беркли. Элвин Берлекемп известен своими работами в области теории кодирования и комбинаторной теории игр.

Роберт Кальдербанк — американский ученый, профессор информатики, электротехники и математики, а также директор информационной инициативы Дюкского университета.

Имре Чисар — венгерский математик, который внёс значительный вклад в развитие теории информации и теории вероятностей.

Йорма Ю. Риссанен — финский теоретик информации, известный как автор принципа минимальной длины описания и практических подходов к арифметического кодирования для сжатия данных без потерь. Его работы вдохновили развитие теории стохастических сетей с памятью переменной длины.

Роберт (Боб) Галлагер — американский учёный, специалист по теории информации. Эмерит-профессор MIT, в котором получил докторскую степень в 1960 году и с тех пор трудился, член Национальных Академии наук и Инженерной академии (1979) США. Лауреат премии Японии (2020) и других отличий.

Дивергенция Йенсена — Шеннона — это метод измерения похожести двух распределений вероятностей. Она известна также как информационный радиус или полное отклонение от среднего. Дивергенция базируется на дивергенции Кульбака — Лейблера с некоторыми существенными отличиями, среди которых, что она симметрична и всегда имеет конечное значение. Квадратный корень из дивергенции Йенсена — Шеннона является метрикой, которая часто упоминается как расстояние Йенсена — Шеннона.

Клод Шеннон

Клод Шеннон Дэвид Слепян[англ.]

Дэвид Слепян[англ.] Уильям Питерсон[англ.]

Уильям Питерсон[англ.] Соломон Голомб

Соломон Голомб Джеймс Мэсси

Джеймс Мэсси

Эндрю Витерби

Эндрю Витерби Форни, Дэвид[англ.]

Форни, Дэвид[англ.] Кайлат, Томас

Кайлат, Томас Роберт Макэлис[англ.]

Роберт Макэлис[англ.] Блейхут, Ричард[англ.]

Блейхут, Ричард[англ.]