Принцип максимума энтропии

Принцип максимума энтропии утверждает, что наиболее характерными распределениями вероятностей состояний неопределенной среды являются такие распределения, которые максимизируют выбранную меру неопределенности при заданной информации о «поведении» среды. Впервые подобный подход использовал Д. Гиббс для нахождения экстремальных функций распределений физических ансамблей частиц. Впоследствии Э. Джейнсом был предложен формализм восстановления неизвестных законов распределения случайных величин при наличии ограничений из условий максимума энтропии Шеннона.

История

Рассмотрим дискретную случайную величину , которая может принимать значения с вероятностями . Значения вероятностей неизвестны. Зато известно математическое ожидание некоторой функции данной случайной величины: . Основываясь на этой информации, каково математическое ожидание функции ?

На первый взгляд, задача кажется неразрешимой, поскольку предварительно необходимо знать вероятностное распределение , а исходной информации недостаточно, чтобы найти все значения вероятностей . Уравнение матожидания функции вместе с уравнением нормировки дают всего два уравнения из необходимых для составления системы уравнений.

Эта задача определения вероятностного распределения в случаях, когда мало или совсем нет информации о случайной величине, стара как сама теория вероятностей. Лапласовский принцип недостаточного основания был попыткой предложить такой критерий выбора: он заключается в том, что два события считаются равновероятными, если нет оснований считать иначе.

Связь статистики с аксиоматической теорией вероятности имеет 2 различных подхода[1]. Частотный (frequentist) подход рассматривает вероятность как предел частоты, вероятность — это то что описывает свойства бесконечно больших ансамблей бинарных событий. Байесов подход обобщает фреквентистский подход тем, что постулирует новый смысл вероятности как количественной характеристики какого-либо бинарного эксперимента. Это даёт те же результаты при описании ансамблей, что и фреквентистский подход, но позволяет давать количественные оценки для бинарных экспериментов, исход которых заранее неизвестен, и улучшать оценки по мере поступления новой информации об исходах; всё это при фреквентистском понимании не имеет смысла.

Лаплас, например, считал, что в мире вообще нет ничего случайного, и если есть информация о причинах событий, то следствия (сами события) могут быть предсказаны со стопроцентной точностью (лапласовский детерминизм). Этот подход к вероятности развивали независимо физик Д.Гиббс (в статистической механике Гиббса) и математик К.Шеннон (при разработке теории информации). Оба они получили величину, выражающую собой меру неопределенности об исходах какого-либо события (или, по-другому, меру неопределенности вероятностного распределения), которая была названа энтропией и вычислялась по похожим формулам. Далее на это сходство обратил внимание физик Э. Т. Джейнс в двух статьях 1957 года[1][2].

Строго говоря, Гиббс не был первопроходцем в разработке понятия физической энтропии. Само понятие энтропии предложил физик Р.Клаузиус, а затем его развивал физик Л.Больцман, причём каждый из них получил свою функцию энтропии. Клаузиус работал с термодинамическими понятиями, Больцман же разрабатывал молекулярную физику и статистическую механику.

Точно так же Шеннон основывался в своей работе на результатах Г.Найквиста и Р.Хартли, заложивших основы теории информации.

Функционал

Предположим, что событие может произойти, а может и не произойти в ходе случайного эксперимента. Если событие не произошло, будем считать, что произошло противоположное событие . Таким образом, события и образуют полную группу событий, что означает, что это несовместные события, а их вероятности в сумме равны единице: .

Если о событии не известно вообще ничего, то, согласно субъективному подходу к вероятности, нужно принять, что события и равновероятны: .

По мере обретения некоторой информации, одна вероятность начнет перевешивать другую, а неопределенность начнет уменьшаться. В конце концов, при получении полной информации окажется, что , (или наоборот: , ). Неопределенность при этом упадет до нуля.

Хорошо бы придумать такую функцию этих вероятностей, которая бы достигала максимума при полной неопределенности и обращалась в ноль при полной определённости. И чем больше одна вероятность перевешивает другую, чем больше между ними «асимметрия», тем меньшее значение принимает данная функция.

Эту функцию (функционал) назовем энтропией распределения или неопределенностью распределения. Строго говоря, энтропия — лишь мера неопределенности, а не сама неопределенность. Но здесь все как в случае с вероятностями: вероятность — это одновременно и возможность события, и мера этой возможности. В принципе, правильно говорить и так, и эдак.

В качестве такой функции можно рассмотреть, например, произведение вероятностей событий и . Обозначим , и рассмотрим функцию . Поскольку — это перевернутая парабола, проходящая через начало координат и точку , то своего максимума она достигает при .

Далее, по мере увеличения «асимметрии» вероятностей, постепенно уменьшается, пока окончательно не превращается в ноль при или при .

В силу симметрии , потому что всё равно, какое именно из двух событий обладает вероятностью , а какое — вероятностью .

С другой стороны, (0,21<0,24), потому что в этом втором случае вероятности более «асимметричны», чем в первом случае.

Функция , где — какой-то коэффициент, тоже справляется с наложенными на неё «обязанностями»: достигает максимума в и минимума (нуля) в и . Это значит, что искомый функционал может быть определён с точностью до некоторого коэффициента.

Пусть теперь полную группу событий образуют три события. Можно и в этом случае рассматривать в качестве энтропии произведение их вероятностей и даже можно доказать, что максимума это произведение достигает, когда все вероятности равны между собой: .

Здесь, правда, возникает одна неприятность. Максимум энтропии для трех событий равен — это меньше, чем максимум энтропии для двух событий, который равен . А хотелось бы, чтоб было наоборот: чем больше событий, тем больше неопределенность.

Другая, более серьёзная неприятность заключается в том, что если вероятность хотя бы одного события равна нулю, то и всё произведение вероятностей автоматически становится равным нулю. То есть неопределенность исчезает, становится равной нулю согласно такому функционалу, хотя на самом деле это не так. Неопределенность должна исчезать, когда все вероятности, кроме одной, равны нулю, а эта единственная вероятность равна единице. Тем не менее, для двух исходов таким функционалом вполне можно пользоваться. Но для двух исходов и не нужно никаких функционалов: если известно матожидание распределения некоторой случайной величины , то уравнение матожидания вместе с условием нормировки как раз дают систему из двух уравнений, из которой однозначно находятся и . Если же о распределении не известно вообще ничего, то вероятности приравниваются друг к другу, а это можно сделать без всяких функционалов.

Энтропия Шеннона

Клод Шеннон наложил на искомую функцию три условия[3]:

- должна быть непрерывной функцией от переменных ;

- если все вероятности равны, то функция является монотонно возрастающей функцией от . Иными словами, ;

- Закон композиции. Вместо того, чтобы задавать вероятности событий непосредственно, можно сгруппировать первые из них вместе, как одно событие с соответствующей вероятностью . Оставшиеся — как второе событие с вероятностью . Тогда функция должна подчиняться условию ;

Закон композиции требует особого рассмотрения, поскольку именно на его основе далее формируется вид функции . Идея заключается в следующем.

Случайный эксперимент разбивается на два последовательных этапа. На первом этапе с вероятностями и выбирается первая (до ) либо вторая (после ) часть исходов. На втором этапе выбирается сам исход из выбранной части исходов. При этом исход из выбранной части выбирается уже с условными вероятностями , то есть при условии, что данная часть (в данном случае, первая часть) выбрана. Сам Шеннон говорит, что если выбор распадается на два этапа, первоначальная энтропия должна быть взвешенной суммой индивидуальных энтропий, то есть условных энтропий.

Общий смысл таков, что если случайный выбор на первом этапе сделан, то вероятности и принимают значения или , и дальнейшая неопределенность равна только одной из условных энтропий.

В качестве примера рассмотрим два графа:

На левом графе есть три исхода с вероятностями , , , образующих полную группу событий (то есть ). На правом графе мы сначала выбираем между двумя возможностями, каждую с вероятностью . Если выбрана вторая возможность, тогда делается ещё один выбор с вероятностями и . Энтропии на обоих графах должны получиться одинаковыми, поскольку в конечном счете получаются те же самые исходы с теми же вероятностями. По закону композиции запишем .

Здесь , поскольку полная группа событий, состоящая всего из одного события, наступающего со стопроцентной вероятностью, порождает нулевую неопределенность. При этом, по словам самого Шеннона, коэффициент появляется потому, что второй выбор появляется только половину всех раз.

В законе композиции первый этап может состоять не из двух возможностей, а из большего числа возможностей с соответствующими вероятностями , , , …

Закон композиции является своеобразным обобщением аддитивного свойства энтропии, хотя и не следует непосредственно из этого свойства. Действительно, пусть некий эксперимент состоит из шести равновероятных исходов. Пусть эти исходы поделены на три равные части: на первом этапе выбирается одна из трех частей, на втором этапе выбирается исход внутри соответствующей части. Тогда можно записать .

Полученное равенство можно переписать так:

.

В общем случае .

Но этот же результат можно получить из других соображений.

Предположим, есть случайный эксперимент с равновероятными исходами и другой случайный эксперимент с равновероятными исходами. Пусть эти два случайных эксперимента никак не связаны друг с другом. Но в любом случае их можно рассматривать как один объединённый эксперимент, в котором отдельный исход заключается в том, что произошел -й исход первого эксперимента и -й исход второго эксперимента. В таком объединённом эксперименте есть уже равновероятных исходов. Поскольку неопределенность двух экспериментов не должна меняться в зависимости от подобной смены точки зрения, то .

Как следствие этого результата, , где — неотрицательное целое. Если , то последнее равенство принимает вид , оставаясь верным равенством.

Закон композиции позволяет выразить энтропию вероятностного распределения, в котором все вероятности — рациональные числа, как взвешенную сумму функций . Действительно, пусть есть полная группа событий из несовместных событий с вероятностями , , …, , где , , — натуральные, . Тогда можно записать

.

Из этого уравнения уже можно выразить .

Не известно точно, откуда Шеннон взял свой закон композиции. Возможно, он хотел, чтобы его энтропия получилась похожей на энтропию Хартли, и он придумал такое условие (закон композиции), из которого энтропия Шеннона получалась бы однозначным образом.

Теорема:

единственная функция , удовлетворяющая трем наложенным на неё условиям Шеннона, имеет вид , где — любая положительная константа, а логарифм же берется по любому основанию больше единицы. |

Доказательство.

Доказательство сводится к выяснению вида функции .

Для любого натурального и любого, сколь угодно большого натурального можно найти такое натуральное и неотрицательное целое , что . Потенцируя обе части неравенства и деля на , получим , откуда . Поскольку основание натурального логарифма больше единицы, то знак неравенств не меняется.

С другой стороны, исходя из монотонности , можно записать , , откуда аналогично , . Тогда можно записать . Переходя к пределу по при , получим . Отсюда , где — произвольная положительная константа, — произвольное натуральное основание логарифма (больше единицы). Произвольность константы связана не только с тем, что она сокращается в числителе и знаменателе, но также и с тем, что основание логарифма выбирается произвольно. Можно перейти к натуральному логарифму, и получится . Это говорит о том, что основание логарифма не обязательно должно быть натуральным числом. Далее, используя представление функции через функцию , можно записать Поскольку любое действительное число можно сколь угодно точно аппроксимировать рациональным числом, а сама функция непрерывна (то есть при небольшом изменении аргумента меняется незначительно), то Шеннон предложил использовать эту формулу и для вероятностей, заданных действительными числами.

Теорема доказана.

Если вероятность равна нулю, то нужно рассматривать предел произведения при , стремящемся к нулю:

Максимум энтропии Шеннона и метод множителей Лагранжа

Можно доказать[4], что энтропия Шеннона принимает максимальное значение на равномерном распределении. Чтобы доказать это, найдем условный максимум энтропии Шеннона при условии нормировки .

Чтобы сделать это, воспользуемся методом множителей Лагранжа для поиска условных экстремумов. Этот метод вкратце заключается в следующем.

Предположим, что требуется найти локальный экстремум непрерывной функции переменных, имеющей частные производные по всем переменным, при условии, что ,…,, где ,…, — непрерывные функции, имеющие частные производные по всем переменным, . Тогда составляется функция Лагранжа вида , где числа называются множителями Лагранжа.

Необходимым условием существования условного экстремума в некоторой точке является равенство нулю либо несуществование всех частных производных её функции Лагранжа в этой точке. Поэтому составляется и решается система из частных производных функции Лагранжа, приравненных к нулю, а также из условий, наложенных на экстремум. Решением системы (если оно существует) является координата экстремума, а также значения множителей Лагранжа.

В случае энтропии Шеннона функция Лагранжа имеет вид: .

Запишем систему уравнений с необходимым условием существования экстремума:

Решая её, получим:

Поскольку все уравнения одинаковы, то , .

Итак, точка, в которой может существовать экстремум, единственная. Учитывая, что функция непрерывная и неотрицательно определённая, принимающая минимальное значение ноль (в случае, когда одна из вероятностей равна единице, а все остальные — нулю), то найденный экстремум является точкой глобального условного максимума, а сам максимум равен .

Можно также доказать, что в наборе вероятностей для несовместных элементарных исходов всякое изменение двух вероятностей в сторону их выравнивания (без изменения числа самих исходов) увеличивает энтропию распределения.

Доказать это просто. Поскольку изменяются только две вероятности, например, и , то остальные вероятности остаются неизменными. Поэтому слагаемые, входящие в формулу энтропии, связанные с остальными вероятностями, останутся неизменными и на приращение энтропии не повлияют. В то же время сумма тоже останется неизменной (по той же причине). Поэтому доказательство достаточно провести всего для двух несовместных исходов, образующих полную группу событий — тогда утверждение можно считать доказанным и для произвольного числа исходов.

Обозначим , и рассмотрим функцию .

Её график зависимости от очень похож на перевернутую параболу, проходящую через начало координат. Максимум достигается в точке . Кроме того, эта функция зеркально симметрична относительно линии . Это следует из того, что . Поэтому, исходя из графика, любое изменение вероятностей в сторону выравнивания приводит к увеличению энтропии.

Энтропия непрерывного распределения

Шеннон первоначально записал[3] следующую формулу для энтропии непрерывного распределения, которая известна также как дифференциальная энтропия:

.

Здесь — неизвестная функция распределения плотности вероятностей случайной величины . (Если , то подынтегральная функция заменяется своим пределом в этой точке .) Однако, в отличие от шенноновской формулы энтропии дискретного распределения, данная формула не является результатом какого-либо вывода (Шеннон просто заменил знак суммы знаком интеграла). И, строго говоря, она не может быть выведена последовательным переходом от дискретной формулы энтропии к непрерывной посредством вычисления предела интегральных частичных сумм интеграла Римана[5] (получится бесконечная величина). Тем не менее, дифференциальная энтропия имеет смысл средней неопределенности выбора случайной величины с произвольным законом распределения за вычетом неопределенности случайной величины, равномерно распределенной в единичном интервале.

Кроме дифференциальной энтропии, известны также англ. Kullback–Leibler divergence и англ. Principle_of_maximum_entropy#Continuous_case. Но далее для объяснения принципа максимальной энтропии будет использована именно дифференциальная энтропия.

Максимум дифференциальной энтропии и вариационное исчисление

Можно доказать, что дифференциальная энтропия принимает максимальное значение на равномерном распределении. Чтобы доказать это, найдем условный максимум дифференциальной энтропии при условии, что .

В этих условиях нужно найти такую функцию , чтобы интеграл дифференциальной энтропии принял максимальное значение. В этом случае сам вид функции становится некой переменной величиной, поэтому необходимо использовать вариационное исчисление[3], основной задачей которого является поиск функции, на которой заданный функционал достигает экстремальных значений.

Метод вариации напоминает метод Лагранжа и вкратце заключается в следующем. Пусть задан функционал с подынтегральной функцией , обладающей непрерывными первыми частными производными, называемой функцией Лагранжа. Если этот функционал достигает экстремума на некоторой функции , то для неё должно выполняться дифференциальное уравнение в частных производных , называемое уравнением Эйлера-Лагранжа. Другими словами, данное уравнение является необходимым условием существования экстремума функционала на функции . Если на функцию накладывается дополнительное условие вида , то искомый экстремум называется условным, а функция Лагранжа принимает вид , и дифференциальное уравнение нужно решать уже для этой новой функции. Найденная функция будет зависеть не только от , но и от параметра . Тогда нужно подставить в интеграл условия и найти .

В случае дифференциальной энтропии функция Лагранжа принимает вид . Тогда , откуда уравнение Эйлера-Лагранжа принимает вид .

Решением этого уравнения является функция , то есть константа от . Подставляем её в условие и получаем .

Такое уравнение не имеет решений. Случайная величина не может быть распределена равномерно на всей области действительных чисел. Пусть все возможные значения лежат на некотором отрезке . Тогда , откуда , . Для всех остальных верно .

Экстремальные распределения

Сам по себе найденный функционал (энтропия Шеннона в дискретной либо дифференциальной форме) пока что ещё ничего не даёт. Поскольку ничего не известно об исходах случайного эксперимента, принцип максимума энтропии предписывает назначить всем исходам равные вероятности. Если же речь идет о непрерывной случайной величине, то предполагается, что она распределена равномерно. Но для того, чтобы провести подобное назначение, никакого функционала не требуется. Функционал позволяет лишь количественно сравнивать неопределенности различных распределений.

Смысл принципа максимальной энтропии начинает проявляться тогда, когда на вероятностное распределение наложены какие-либо ограничения. Принцип максимума энтропии в этом случае заключается в том, чтобы найти максимум энтропии при наложенных ограничениях. Полученное таким образом распределение называется экстремальным.

Найдём максимум энтропии в случаях, когда на распределение случайной величины наложены какие-либо ограничения, например, известны какие-либо её моменты. При использовании метода множителей Лагранжа и метода вариационного исчисления будет показано, что:

- если известно матожидание или второй начальный момент, или и то, и другое дискретной случайной величины, то её экстремальное распределение является одной из разновидностей дискретного распределения Гиббса

- если известно матожидание непрерывной случайной величины, то её экстремальное распределение является непрерывным распределением Гиббса

- если известны матожидание и дисперсия непрерывной случайной величины, то её экстремальное распределение является нормальным распределением с этими параметрами. Если матожидание не известно, оно назначается равным нулю.

О случайной величине не известно ничего (дискретный и непрерывный случаи)

В этом случае принцип максимума энтропии предписывает считать, что случайная величина распределена равномерно. Уже было показано ранее, что энтропия Шеннона в любой (дискретной либо непрерывной) форме принимает максимально возможное значение на таком распределении.

Известно только матожидание (дискретный случай)

Предположим, что известно только матожидание дискретного распределения вероятностей некоторой случайной величины : . Каково в этом случае само распределение? На распределение накладываются дополнительные ограничения:

Согласно принципу максимальной энтропии нужно максимизировать при этих условиях функцию

Составим функцию Лагранжа и найдем точки возможного экстремума:

Система из частных производных и наложенных условий имеет вид:

Вычитая из первого уравнения -е, получим .

Объединяя полученное уравнение в систему с условием нормировки и решая её, получим:

, откуда .

Теперь из -го уравнения следует .

Наконец, исходя из уравнения для матожидания, можно записать , откуда следует .

Окончательно исходная система может быть представлена в виде:

Достаточно легко доказать, что решение второго уравнения системы относительно всегда существует и единственно, пусть и не всегда представимо в виде явной функции аргумента . При желании (хотя и не обязательно) можно из третьего уравнения выразить через . Но, самое главное, при подстановке в первое уравнение, получится дискретное вероятностное распределение с матожиданием .

Поскольку найденное решение единственно, то найденная точка скорее всего является экстремумом энтропии, причем, этот экстремум — глобальный условный максимум.

Найденное вероятностное распределение называется англ. Boltzmann_distribution, которое также известно как распределение Гиббса.

Известен только второй начальный момент (дискретный случай)

Предположим, что известен только второй начальный момент дискретного распределения вероятностей некоторой случайной величины : . Каково в этом случае само распределение?

Этот случай ничем не отличается от предыдущего, за исключением того, что величины нужно заменить величинами , нужно заменить на . Окончательно распределение будет иметь вид

Легко видеть в этом случае, что, если , то .

Известны матожидание и второй начальный момент (дискретный случай)

Функция Лагранжа в этом случае имеет вид

Система уравнений, являющаяся необходимым условием существования экстремума, имеет вид:

. Её можно привести к виду

Задача доказательства существования и единственности решения в данном случае гораздо более сложная. Тем более, задача нахождения параметров и из второго и третьего уравнений системы. Однако, если доказательство возможно, тогда экстремальное распределение с заданными параметрами будет иметь как раз найденный вид.

Известно только матожидание (непрерывный случай)

Предположим, что известно только матожидание непрерывного распределения вероятностей некоторой случайной величины : . Какова в этом случае функция распределения плотности вероятностей?

На распределение накладываются дополнительные ограничения:

Согласно принципу максимальной энтропии нужно максимизировать при этих условиях функцию

Составим функцию Лагранжа и найдем , для которой возможен экстремум :

Уравнение Эйлера-Лагранжа в данном случае имеет вид .

Его решением является функция , то есть экспонента.

Площадь под графиком такой функции может быть конечной только в том случае, если к бесконечности устремить не более одного предела интегрирования. Поэтому будем считать, что случайная величина может принимать значения только на некоторой конечной или полубесконечной области , не обязательно односвязной. Во всех остальных точках функцию будем считать равной нулю.

Чтобы найти значения коэффициентов и , нужно составить систему уравнений из наложенных на распределение условий и решить её. Система имеет вид:

и может быть приведена к виду .

Здесь все интегралы — «берущиеся», поэтому можно однозначно выразить через — стоит лишь более конкретно задать область . При этом найденное решение единственно.

Поскольку коэффициент однозначно выражается через , то и он единственнен. В силу единственности найденного решения функция доставляет максимум функционалу . Функция при этом имеет вид .

Найденное распределение называется распределением Больцмана (или Гиббса) непрерывной случайной величины.

Известен только второй начальный момент (непрерывный случай)

Предположим, что известен только второй начальный момент распределения вероятностей некоторой непрерывной случайной величины : . Каково в этом случае само распределение?

Функция Лагранжа в этом случае имеет вид .

Уравнение Эйлера-Лагранжа имеет вид .

Его решением является функция .

Площадь под графиком может быть конечной только в случае . Если , то получается равномерное распределение, которое уже было рассмотрено ранее.

Чтобы найти значения коэффициентов и , нужно составить систему уравнений из наложенных на распределение условий и решить её:

Поскольку здесь присутствует определённый интеграл Эйлера-Пуассона, то систему можно записать в виде:

, откуда окончательно

Итак, распределение является нормальным распределением с нулевым матожиданием и дисперсией .

Известны матожидание и второй начальный момент (непрерывный случай)

Функция Лагранжа в этом случае имеет вид .

Уравнение Эйлера-Лагранжа имеет вид .

Его решением является функция .

Опять примем .

Чтобы найти значения коэффициентов , , , нужно составить систему уравнений из наложенных на распределение условий и решить её:

Степень числа в интегралах может быть представлена в виде: , где , .

Тогда

,

откуда

.

является дисперсией распределения .

Окончательно функцию можно записать в виде .

Итак, получилось нормальное распределение с матожиданием и дисперсией .

Изначально можно было задать не второй начальный момент распределения, а его дисперсию, и всё равно получилось бы нормальное распределение с заданными параметрами.

Таблица экстремальных распределений

В таблице ниже каждое перечисленное распределение максимизирует энтропию при наложенных на распределение условиях, указанных в третьем столбце. В четвёртом столбце указана область определения случайной величины.

| Распределение | Функция вероятности/ плотность вероятности | Ограничения, наложенные на распределение | Область определения случайной величины |

|---|---|---|---|

| Равномерное | Нет | ||

| Равномерное | Нет | ||

| Бернулли | |||

| Геометрическое | |||

| Экспоненциальное | |||

| Лапласа | |||

| англ. Asymmetric_Laplace_distribution | |||

| Парето | |||

| Нормальное | |||

| англ. Von_Mises_distribution | |||

| Рэлея | |||

| Бета | |||

| Коши | |||

| Хи-распределение | |||

| хи-квадрат | |||

| англ. Erlang_distribution | |||

| Гамма | |||

| Логнормальное | |||

| Максвелла | |||

| Вейбулла | |||

| Многомерное | |||

| Биномиальное | |||

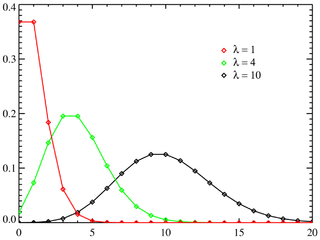

| Пуассона |

См. также

- Информационный критерий Акаике

- Диссипация энергии

- Информационная энтропия

- Метод максимального правдоподобия

- Задача о двух конвертах

Примечания

- ↑ 1 2 Jaynes, E. T. Information Theory and Statistical Mechanics (англ.) // Physical Review : journal. — 1957. — Vol. Series II, no. 4. — P. 620—630. — doi:10.1103/PhysRev.106.620. — . Архивировано 14 мая 2011 года.

- ↑ Jaynes, E. T. Information Theory and Statistical Mechanics II (англ.) // Physical Review : journal. — 1957. — Vol. Series II, no. 2. — P. 171—190. — doi:10.1103/PhysRev.108.171. — . Архивировано 14 мая 2011 года.

- ↑ 1 2 3 C.E. Shannon. A Mathematical Theory of Communication. Архивировано 29 марта 2016 года.

- ↑ И.Н. Бекман. Информатика. Курс лекций. — С. Этапы формирования понятия энтропии. Архивировано 13 декабря 2016 года.

- ↑ В.А. Фурсов. Теория информации. — Самара: СГАУ, 2011. — С. 15.

Литература

- Голицын Г.А. Информация и творчество. — М.: Русский мир, 1997. — 304 с. — ISBN 5-85810-039-2.

- Ю. Г. Рудой. Обобщенная информационная энтропия и неканоническое распределение в равновесной статистической механике

- Jaynes, E. T. Information Theory and Statistical Mechanics // Statistical Physics (англ.) / Ford, K. (ed.). — New York: Benjamin, 1963. — P. 181.

- Jaynes, E. T., 1986 (new version online 1996), 'Monkeys, kangaroos and ', in Maximum-Entropy and Bayesian Methods in Applied Statistics, J. H. Justice (ed.), Cambridge University Press, Cambridge, p. 26.

- Bajkova, A. T., 1992, The generalization of maximum entropy method for reconstruction of complex functions. Astronomical and Astrophysical Transactions, V.1, issue 4, p. 313—320.

- Giffin, A. and Caticha, A., 2007, Updating Probabilities with Data and Moments

- Guiasu, S. and Shenitzer, A., 1985, 'The principle of maximum entropy', The Mathematical Intelligencer, 7(1), 42-48.

- Harremoës P. and Topsøe F., 2001, Maximum Entropy Fundamentals, Entropy, 3(3), 191—226.

- Kapur, J. N.; and Kesavan, H. K., 1992, Entropy optimization principles with applications, Boston: Academic Press. ISBN 0-12-397670-7

- Kitamura, Y., 2006, Empirical Likelihood Methods in Econometrics: Theory and Practice, Cowles Foundation Discussion Papers 1569, Cowles Foundation, Yale University.

- Lazar, N., 2003, «Bayesian Empirical Likelihood», Biometrika, 90, 319—326.

- Owen, A. B., Empirical Likelihood, Chapman and Hall.

- Schennach, S. M., 2005, «Bayesian Exponentially Tilted Empirical Likelihood», Biometrika, 92(1), 31-46.

- Uffink, Jos, 1995, 'Can the Maximum Entropy Principle be explained as a consistency requirement?', Studies in History and Philosophy of Modern Physics 26B, 223—261.

![{\displaystyle M[f(x)]=\sum \limits _{i=1}^{n}{f({x_{i}}){p_{i}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5955e8d1b61bc297e07431b457cae484ff634149)

![{\displaystyle [a;b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/68e776d74130a8890a814c1f4e74372a9110d2f9)

![{\displaystyle M[X]=\sum \limits _{i=1}^{n}{{x_{i}}{p_{i}}}=m}](https://wikimedia.org/api/rest_v1/media/math/render/svg/276645af16f92d3d8e3179c66b65f13d14b11266)

![{\displaystyle M[X]=\int \limits _{-\infty }^{\infty }{xf(x)dx}=m}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dbdd4bc6bf2125f237b6d6158c47dbdb298cd3ce)

![{\displaystyle [a,b]\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/23cb97ebba2cd3175f9a77446963c1849fc353ee)

![{\displaystyle M[k]=p\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2fe18b83b771a86b2161ec5823f9b6aab9a9ed73)

![{\displaystyle M[k]={\frac {1}{p}}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bafd686c032a0795c11ff3c595d96fea82f2161a)

![{\displaystyle M[x]={\frac {1}{\lambda }}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5a525789c281a383d18020e075451726ae7d8201)

![{\displaystyle M[|x-\mu |]=b\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b885c09cf92cdfe0be355ad8bc5b9903c2912536)

![{\displaystyle M[(x-m)s\kappa ^{s}]=1/\lambda \,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c2e9b6ee4fe1d549826135466d0510583ea5b793)

![{\displaystyle M[\ln(x)]={\frac {1}{\alpha }}+\ln(x_{m})\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/447957640093491c13819eb0c01a61f9f3d1f583)

![{\displaystyle {\begin{array}{l}M[x]=\mu ,\,\\M[(x-\mu )^{2}]=\sigma ^{2}\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3fa4cb9ef00f8756bfcf1dec6359b7c9138578f7)

![{\displaystyle {\begin{array}{l}M[\cos \theta ]={\frac {I_{1}(\kappa )}{I_{0}(\kappa )}}\cos \mu ,\,\\M[\sin \theta ]={\frac {I_{1}(\kappa )}{I_{0}(\kappa )}}\sin \mu \\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1129b35f198fc98ae109c338cee7ed3553848ac5)

![{\displaystyle {\begin{array}{l}M[x^{2}]=2\sigma ^{2},\\M[\ln(x)]={\frac {\ln(2\sigma ^{2})-\gamma _{E}}{2}}\,\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bd13ef31decf7b28ad885db4fb8b0811d145089d)

![{\displaystyle {\begin{array}{l}M[\ln(x)]=\psi (\alpha )-\psi (\alpha +\beta ),\,\\M[\ln(1-x)]=\psi (\beta )-\psi (\alpha +\beta )\,\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d68db3bfb4818219e3954a7135bf4ce6650d48e4)

![{\displaystyle [0,1]\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/43e2b417e116123c724ee6f69cf309f6ad17a2d0)

![{\displaystyle M[\ln(1+x^{2})]=2\ln 2}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0ad1a58b33730c32d3e55b454e466a682b97690)

![{\displaystyle {\begin{array}{l}M[x^{2}]=k,\,\\M[\ln(x)]={\frac {1}{2}}\left[\psi \left({\frac {k}{2}}\right)\!+\!\ln(2)\right]\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aa0a2bb0b589e747a399a39af40851ad5a5eda7c)

![{\displaystyle {\begin{array}{l}M[x]=k,\,\\M[\ln(x)]=\psi \left({\frac {k}{2}}\right)+\ln(2)\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f5e3f53be30360412f64becc93b8f88eb4b7ab01)

![{\displaystyle {\begin{array}{l}M[x]=k/\lambda ,\,\\M[\ln(x)]=\psi (k)-\ln(\lambda )\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7946f1de8e75098d31b16414b92e6e9e25f08945)

![{\displaystyle {\begin{array}{l}M[x]=k\theta ,\,\\M[\ln(x)]=\psi (k)+\ln(\theta )\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc4eaa5dac05175b5de083f064353512ea8d5e93)

![{\displaystyle {\begin{array}{l}M[\ln(x)]=\mu ,\\M[(\ln(x)-\mu )^{2}]=\sigma ^{2}\,\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70e1a4d1f586f449c0c1d0c4b975ac46b3735408)

![{\displaystyle {\begin{array}{l}M[x^{2}]=3a^{2},\,\\M[\ln(x)]\!=\!1\!+\!\ln \left({\frac {a}{\sqrt {2}}}\right)\!-\!{\frac {\gamma _{E}}{2}}\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/69d065930ab9dc48b701d8df13b091bfd810700d)

![{\displaystyle {\begin{array}{l}M[x^{k}]=\lambda ^{k},\\M[\ln(x)]=\ln(\lambda )-{\frac {\gamma _{E}}{k}}\,\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/68fe545bb3bbc397436d2f0d34b7b7449084c84a)

![{\displaystyle {\begin{array}{l}M[{\vec {x}}]={\vec {\mu }},\,\\M[({\vec {x}}-{\vec {\mu }})({\vec {x}}-{\vec {\mu }})^{T}]=\Sigma \,\\\end{array}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a1e7906f999c864f686ef8c6d54738d2610c5539)