Шифрова́ние — обратимое преобразование информации в целях сокрытия от неавторизованных лиц с предоставлением в это же время авторизованным пользователям доступа к ней. Главным образом, шифрование служит для соблюдения конфиденциальности передаваемой информации. Важной особенностью любого алгоритма шифрования является использование ключа, который утверждает выбор конкретного преобразования из совокупности возможных для данного алгоритма.

Информацио́нная энтропи́я — мера неопределённости некоторой системы, в частности, непредсказуемость появления какого-либо символа первичного алфавита. В последнем случае при отсутствии информационных потерь энтропия численно равна количеству информации на символ передаваемого сообщения.

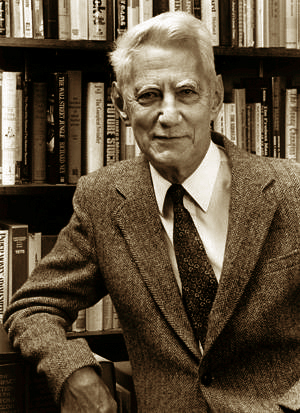

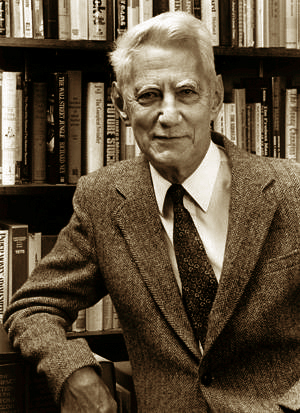

Клод Э́лвуд Ше́ннон — американский инженер, криптоаналитик и математик. Считается «отцом информационного века».

Теоремы Шеннона для канала с шумами связывают пропускную способность канала передачи информации и существование кода, который возможно использовать для передачи информации по каналу с ошибкой, стремящейся к нулю.

Теория информации — раздел прикладной математики, радиотехники и информатики, относящийся к измерению количества информации, её свойств и устанавливающий предельные соотношения для систем передачи данных. Как и любая математическая теория, теория оперирует математическими моделями, а не реальными физическими объектами. Использует, главным образом, математический аппарат теории вероятностей и математической статистики.

Универсальный код для целых чисел в сжатии данных — префиксный код, который преобразует положительные целые числа в двоичные слова, с дополнительным свойством: при любом истинном распределение вероятностей на целых числах, пока распределение — монотонно, ожидаемые длины двоичных слов находятся в пределах постоянного фактора ожидаемых длин, которые оптимальный код назначил бы для этого распределения вероятностей.

Код — взаимно однозначное отображение конечного упорядоченного множества символов, принадлежащих некоторому конечному алфавиту, на иное, не обязательно упорядоченное, как правило более обширное множество символов для кодирования передачи, хранения или преобразования информации.

Расстояние Ку́льбака — Ле́йблера, РКЛ, информационное расхождение, различающая информация, информационный выигрыш, относительная энтропия — неотрицательнозначный функционал, являющийся несимметричной мерой удалённости друг от друга двух вероятностных распределений, определённых на общем пространстве элементарных событий. Часто применяется в теории информации и математической статистике.

В области математики и теории информации линейный код — тип блокового кода, использующийся в схемах определения и коррекции ошибок. Линейные коды, по сравнению с другими кодами, позволяют реализовывать более эффективные алгоритмы кодирования и декодирования информации.

Теоремы Шеннона для источника без памяти связывают энтропию источника и возможность сжатия кодированием с потерями и последующим неоднозначным декодированием.

В теории информации теорема Шеннона об источнике шифрования устанавливает предел максимального сжатия данных и числовое значение энтропии Шеннона.

Теорема Шеннона — Хартли в теории информации — применение теоремы кодирования канала с шумом к архетипичному случаю непрерывного временно́го аналогового канала коммуникаций, искажённого гауссовским шумом. Теорема устанавливает шенноновскую ёмкость канала, верхнюю границу максимального количества безошибочных цифровых данных, которое может быть передано по такой связи коммуникации с указанной полосой пропускания в присутствии шумового вмешательства, согласно предположению, что мощность сигнала ограничена, и гауссовский шум характеризуется известной мощностью или спектральной плотностью мощности. Закон назван в честь Клода Шеннона и Ральфа Хартли.

В теории кодирования, неравенство Крафта — Макмиллана даёт необходимое и достаточное условие существования разделимых и префиксных кодов, обладающих заданным набором длин кодовых слов.

Дифференциальная энтропия — формальное обобщение понятия информационной энтропии Шеннона для случая непрерывной случайной величины. В теории информации интерпретируется как средняя информация непрерывного источника. В случае одномерной случайной величины определяется как

бит

бит

Принцип максимума энтропии утверждает, что наиболее характерными распределениями вероятностей состояний неопределенной среды являются такие распределения, которые максимизируют выбранную меру неопределенности при заданной информации о «поведении» среды. Впервые подобный подход использовал Д.Гиббс для нахождения экстремальных функций распределений физических ансамблей частиц. Впоследствии Э.Джейнсом был предложен формализм восстановления неизвестных законов распределения случайных величин при наличии ограничений из условий максимума энтропии Шеннона.

В области сжатия данных, код Шеннона, названный в честь его создателя, Клода Шеннона, — это алгоритм сжатия данных без потерь с помощью построения префиксных кодов на основе набора символов и их вероятностей. Он является субоптимальным в том смысле, что не позволяет достичь минимально возможных кодовых длин как в кодировании Хаффмана, и никогда не будет лучше, но иногда равным с кодом Шеннона-Фано.

Теорема Копперсмита — теорема, позволяющая эффективно найти все нули нормированных многочленов по определённому модулю.

Дивергенция Йенсена — Шеннона — это метод измерения похожести двух распределений вероятностей. Она известна также как информационный радиус или полное отклонение от среднего. Дивергенция базируется на дивергенции Кульбака — Лейблера с некоторыми существенными отличиями, среди которых, что она симметрична и всегда имеет конечное значение. Квадратный корень из дивергенции Йенсена — Шеннона является метрикой, которая часто упоминается как расстояние Йенсена — Шеннона.

Кодирование по Танстеллу — форма энтропийного кодирования, используемая для сжатия данных без потерь.