Компью́тер — функциональное устройство, способное выполнять значительный объём вычислений, включая многочисленные арифметические и логические операции, без вмешательства человека. Компьютер может быть как отдельным блоком, так и состоять из нескольких взаимосвязанных устройств. Является синонимом терминов «электронная вычислительная машина», «вычислительная система».

Компью́терная па́мять — часть вычислительной машины, физическое устройство или среда для хранения данных, используемая в вычислениях систем в течение определённого времени. Память, и центральный процессор, неизменно является частью компьютера с 1940-х годов. Память в вычислительных устройствах имеет иерархическую структуру и обычно предполагает использование нескольких запоминающих устройств, имеющих различные характеристики.

Операцио́нная систе́ма, сокр. ОС — программное обеспечение, управляющее компьютерами и позволяющее запускать на них прикладные программы. Предоставляет программный интерфейс для взаимодействия с компьютером, управляет прикладными программами и занимается распределением предоставляемых ресурсов, в том числе между прикладными программами. Некоторые операционные системы позволяют прикладным программам работать с аппаратным обеспечением напрямую. В широком смысле под операционной системой понимается совокупность ядра операционной системы и работающих поверх него программ и утилит, предоставляющих интерфейс для взаимодействия пользователя с компьютером.

Центра́льный проце́ссор — электронный блок либо интегральная схема, исполняющая машинные инструкции, главная часть аппаратного обеспечения компьютера или программируемого логического контроллера. Иногда этот компонент называют просто процессором.

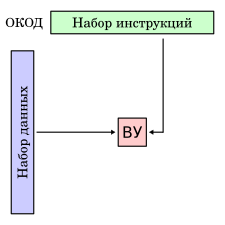

Архитектура фон Неймана — широко известный принцип совместного хранения команд и данных в памяти компьютера. Вычислительные машины такого рода часто обозначают термином «машина фон Неймана», однако соответствие этих понятий не всегда однозначно. В общем случае, когда говорят об архитектуре фон Неймана, подразумевают принцип хранения данных и инструкций в одной памяти. Альтернативой архитектуре фон Неймана является гарвардская архитектура.

«Клиент — сервер» — вычислительная или сетевая архитектура, в которой задания или сетевая нагрузка распределены между поставщиками услуг, называемыми серверами, и заказчиками услуг, называемыми клиентами. Фактически клиент и сервер — это программное обеспечение. Обычно эти программы расположены на разных вычислительных машинах и взаимодействуют между собой через вычислительную сеть посредством сетевых протоколов, но они могут быть расположены также и на одной машине. Программы-сервера ожидают от клиентских программ запросы и предоставляют им свои ресурсы в виде данных или в виде сервисных функций. Поскольку одна программа-сервер может выполнять запросы от множества программ-клиентов, её размещают на специально выделенной вычислительной машине, настроенной особым образом, как правило, совместно с другими программами-серверами, поэтому производительность этой машины должна быть высокой. Из-за особой роли такой машины в сети, специфики её оборудования и программного обеспечения, её также называют сервером, а машины, выполняющие клиентские программы, соответственно, клиентами.

Параллельные вычислительные системы — физические компьютерные, а также программные системы, реализующие тем или иным способом параллельную обработку данных на многих вычислительных узлах.

Вычислительная техника является важнейшим компонентом процесса вычислений и обработки данных. Первыми приспособлениями для вычислений были, вероятно, всем известные счётные палочки, которые и сегодня используются в начальных классах многих школ для обучения счёту. Развиваясь, эти приспособления становились более сложными, например, такими как финикийские глиняные фигурки, также предназначаемые для наглядного представления количества считаемых предметов. Такими приспособлениями, похоже, пользовались торговцы и счетоводы того времени.

Симметричная многопроцессорность — архитектура многопроцессорных компьютеров, в которой два или более одинаковых процессора сравнимой производительности подключаются единообразно к общей памяти и выполняют одни и те же функции. В английском языке SMP-системы носят также название tightly coupled multiprocessors, так как в этом классе систем процессоры тесно связаны друг с другом через общую шину и имеют равный доступ ко всем ресурсам вычислительной системы и управляются все одной копией операционной системы.

SIMD — принцип компьютерных вычислений, позволяющий обеспечить параллелизм на уровне данных. Один из классов вычислительных систем в классификации Флинна.

Суперскалярный процессор — процессор, поддерживающий так называемый параллелизм на уровне инструкций за счёт включения в состав его вычислительного ядра нескольких одинаковых функциональных узлов. Планирование исполнения потока инструкций осуществляется динамически вычислительным ядром.

Многоя́дерный проце́ссор — центральный процессор, содержащий два и более вычислительных ядра на одном процессорном кристалле или в одном корпусе.

MIMD — концепция архитектуры компьютера, используемая для достижения параллелизма вычислений. Один из классов вычислительных систем в классификации Флинна.

MISD-Архитектура — тип архитектуры параллельных вычислений, где несколько функциональных модулей выполняют различные операции над одними данными. Один из классов вычислительных систем в классификации Флинна.

Многопроцессорность — использование пары или большего количества физических процессоров в одной компьютерной системе.

Таксономия (Классификация) Флинна — общая классификация архитектур ЭВМ по признакам наличия параллелизма в потоках команд и данных. Была предложена Майклом Флинном в 1966 году и расширена в 1972 году.

Распределённые вычисления — способ решения трудоёмких вычислительных задач с использованием нескольких компьютеров, чаще всего объединённых в параллельную вычислительную систему. Распределённые вычисления применимы также в распределённых системах управления.

В программировании, SPMD является методом, используемым для достижения параллелизма; это подкатегория MIMD-класса вычислительных систем в классификации Флинна.

В параллельных компьютерных архитектурах систолический массив представляет собой однородную сеть тесно связанных блоков обработки данных (DPU), называемых ячейками или узлами. Каждый узел независимо и параллельно вычисляет частичный результат как функцию данных, полученных от его вышестоящих соседей, сохраняет результат внутри себя и передает его нижестоящим узлам. Систолические массивы были впервые использованы в Colossus Mark II в 1944 году, одном из первых компьютеров, использовавшихся для взлома немецких шифров Лоренца. Из-за секретности компьютеров Colossus систолические массивы были независимо заново открыты Х. Т. Кунгом и Чарльзом Лейзерсоном, которые описали массивы для множества вычислений плотной линейной алгебры для ленточных матриц. Ранние применения включают вычисление наибольших общих делителей целых чисел и многочленов. Иногда их классифицируют как архитектуры с несколькими инструкциями и одними данными (MISD) согласно таксономии Флинна, но эта классификация вызывает сомнения, поскольку можно предложить убедительные аргументы для выделения систолических массивов в отдельную группу, отличную от любой из четырех категорий Флинна: SISD, SIMD, MISD, MIMD, как это обсуждается позже в этой статье.