Тео́рия управле́ния — наука о принципах и методах управления различными системами, процессами и объектами.

H.264, MPEG-4 Part 10 или AVC — лицензируемый стандарт сжатия видео, предназначенный для достижения высокой степени сжатия видеопотока при сохранении высокого качества.

Метод обратного распространения ошибки — метод вычисления градиента, который используется при обновлении весов многослойного перцептрона. Впервые метод был описан в 1974 г. А. И. Галушкиным, а также независимо и одновременно Полом Дж. Вербосом. Далее существенно развит в 1986 г. Дэвидом И. Румельхартом, Дж. Е. Хинтоном и Рональдом Дж. Вильямсом и независимо и одновременно С.И. Барцевым и В.А. Охониным. Это итеративный градиентный алгоритм, который используется с целью минимизации ошибки работы многослойного перцептрона и получения желаемого выхода.

Пропорционально-интегрально-дифференцирующий (ПИД) регулятор — устройство в управляющем контуре с обратной связью. Используется в системах автоматического управления для формирования управляющего сигнала с целью получения необходимых точности и качества переходного процесса. ПИД-регулятор формирует управляющий сигнал, являющийся суммой трёх слагаемых, первое из которых пропорционально разности входного сигнала и сигнала обратной связи, второе — интеграл сигнала рассогласования, третье — производная сигнала рассогласования.

Градиентный спуск, метод градиентного спуска — численный метод нахождения локального минимума или максимума функции с помощью движения вдоль градиента, один из основных численных методов современной оптимизации.

Эволюционные алгоритмы — направление в искусственном интеллекте, которое использует и моделирует процессы естественного отбора.

Расчётная (вычислительная) сетка — совокупность точек, заданных в области определения некоторой функции  .

.

Дифференциа́льная эволю́ция — метод многомерной математической оптимизации, относящийся к классу стохастических алгоритмов оптимизации и использующий некоторые идеи генетических алгоритмов.

Нау́м Зу́селевич Шор — советский и украинский математик, с 1998 года — академик Национальной академии наук Украины.

Алекса́ндр Льво́вич Фрадко́в — советский и российский учёный, доктор технических наук (1986), профессор.

Поиск восхождением к вершине — это техника математической оптимизации, принадлежащая семейству алгоритмов локального поиска. Алгоритм является методом итерации, который начинается с произвольного решения задачи, а затем пытается найти лучшее решение путём пошагового изменения одного из элементов решения. Если решение даёт лучшее решение, делается приращение для получения нового решения и оно делается, пока не достигнем момента, в котором улучшение найти не удаётся.

Онлайновое машинное обучение — это метод машинного обучения, в котором данные становятся доступными в последовательном порядке и используются для обновления лучшего предсказания для последующих данных, выполняемого на каждом шаге обучения. Метод противоположен пакетной технике обучения, в которой лучшее предсказание генерируется за один раз, исходя из полного тренировочного набора данных. Онлайновое обучение является общей техникой, используемой в областях машинного обучения, когда невозможна тренировка по всему набору данных, например, когда возникает необходимость в алгоритмах, работающих с внешней памятью. Метод используется также в ситуациях, когда алгоритму приходится динамически приспосабливать новые схемы в данных или когда сами данные образуются как функция от времени, например, при предсказании цен на фондовом рынке. Алгоритмы онлайнового обучения могут быть склонны к катастрофическим помехам, проблеме, которая может быть решена с помощью подхода пошагового обучения.

Выпуклое программирование — это подобласть математической оптимизации, которая изучает задачу минимизации выпуклых функций на выпуклых множествах. В то время как многие классы задач выпуклого программирования допускают алгоритмы полиномиального времени, математическая оптимизация в общем случае NP-трудна.

Субградиентные методы — итеративные методы решения задач выпуклой минимизации. Субградиентные методы, разработанные Наумом Зуселевичем Шором сходятся, даже если применяются к недифференцируемым целевым функциям. Когда функция дифференцируема, субградиентные методы для задач без ограничений используют то же направление поиска, что и метод наискорейшего спуска.

Стохастический градиентный спуск — итерационный метод для оптимизации целевой функции с подходящими свойствами гладкости. Его можно расценивать как стохастическую аппроксимацию оптимизации методом градиентного спуска, поскольку он заменяет реальный градиент, вычисленный из полного набора данных, оценкой, вычисленной из случайно выбранного подмножества данных. Это сокращает задействованные вычислительные ресурсы и помогает достичь более высокой скорости итераций в обмен на более низкую скорость сходимости. Особенно большой эффект достигается в приложениях, связанных с обработкой больших данных.

Методы Розенброка — ряд численных методов, названных по имени Ховарда Г. Розенброка.

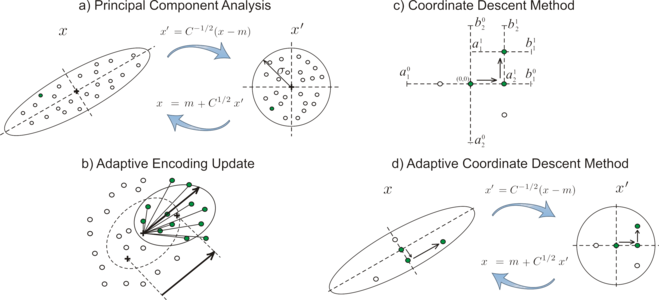

Координатный спуск — алгоритм оптимизации, который последовательно проводит минимизацию функции вдоль координатных направлений. На каждой итерации, алгоритм определяет координатную переменную или координатный блок посредством правила выбора координат, затем точно или приближённо минимизирует по соответствующей координатной гиперплоскости при фиксировании других координат или координатных блоков. На текущей итерации может быть осуществлён линейный поиск вдоль координатного направления, чтобы найти подходящий размер шага. Координатный спуск может быть применён как в дифференцируемом случае, так и в случае контекста, когда производные не вычисляются.

Рандомизированный (блочный) координатный спуск — алгоритм оптимизации, популяризованный Нестеровым (2010) и Ричтариком и Такачем (2011). Первый анализ метода, когда он применяется к задаче минимизации гладкой выпуклой функции, был осуществлён Нестеровым (2010). В анализе Нестерова метод следует применять к квадратичным возмущениям исходной функции с неизвестным поправочным коэффициентом. Ричтарик и Такач (2011) дали границы сложности итераций без такого требования, то есть метод применяется к целевой функции напрямую. Более того, они обобщили постановку к задаче минимизации сложной функции, то есть суммы гладкой функции и выпуклой блочно-разделимой функции:

В машинном обучении, ранняя остановка — форма регуляризации, используемая для избежания переобучения при обучении модели с помощью итеративного метода, например, такого, как градиентный спуск. При использовании подобных методов модель обновляется после каждой итерации для того, чтобы лучше соответствовать обучающим данным и до определенного момента это улучшает производительность модели также и на данных, не входящих в обучающий набор, но после этого момента улучшение соответствия модели обучающим данным происходит за счёт увеличения ошибки обобщения. Правила ранней остановки являются руководством по определению того, как много итераций может пройти, перед переобучением модели и они используются во множестве методов машинного обучения.

В машинном обучении и статистике, темп обучения — настраиваемый параметр алгоритма оптимизации, который определяет размер шага на каждой итерации, при движении к минимуму функции потерь. Поскольку он влияет на то, в какой степени вновь полученная информация превосходит старую, он метафорически представляет скорость, с которой модель машинного обучения «обучается». В литературе, посвященной адаптивному управлению, темп обучения обычно называется приростом (gain).