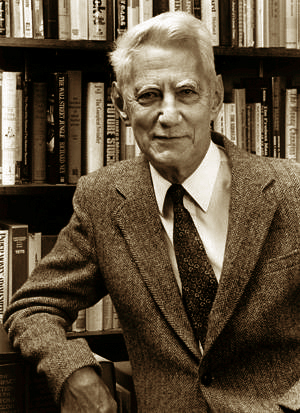

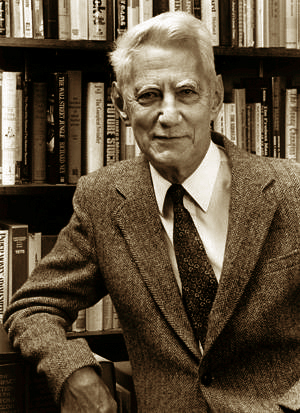

Клод Э́лвуд Ше́ннон — американский инженер, криптоаналитик и математик. Считается «отцом информационного века».

Реле́ — электричекий силовой, слаботочный или иной элемент автоматических устройств, который при воздействии на него внешних физических явлений скачкообразно принимает конечное число значений выходной величины. Реле отличается от релейного устройства, которое может быть автономным — без воспринимающих устройств, за исключением пусковых ключей.

Влади́мир Алекса́ндрович Коте́льников — советский и российский учёный в области радиофизики, радиотехники, электроники, информатики, радиоастрономии и криптографии. Один из основоположников советской секретной радио- и телефонной связи. Академик АН СССР (23.10.1953), академик РАН, вице-президент АН СССР (1970—1988). Дважды Герой Социалистического Труда. 4-й кавалер ордена «За заслуги перед Отечеством» I степени (2003).

Цифрова́я обрабо́тка сигна́лов — способы обработки сигналов на основе численных методов с использованием цифровой вычислительной техники.

Теоремы Шеннона для канала с шумами связывают пропускную способность канала передачи информации и существование кода, который возможно использовать для передачи информации по каналу с ошибкой, стремящейся к нулю.

Тепловой шум — равновесный шум, обусловленный тепловым движением носителей заряда в проводнике, в результате чего на концах проводника возникает флуктуирующая разность потенциалов.

Теория информации — раздел прикладной математики, радиотехники и информатики, относящийся к измерению количества информации, её свойств и устанавливающий предельные соотношения для систем передачи данных. Как и любая математическая теория, теория оперирует математическими моделями, а не реальными физическими объектами. Использует, главным образом, математический аппарат теории вероятностей и математической статистики.

Флуктуа́ция — любое случайное отклонение какой-либо величины. В квантовой механике — отклонение от среднего значения случайной величины, характеризующей систему из большого числа хаотично взаимодействующих частиц; такие отклонения вызываются тепловым движением частиц или квантовомеханическими эффектами.

Критерий устойчивости Найквиста — Михайлова — один из способов судить об устойчивости замкнутой системы управления по амплитудно-фазовой частотной характеристике её разомкнутого состояния. Является одним из частотных критериев устойчивости. С помощью этого критерия оценить устойчивость весьма просто, без необходимости вычисления полюсов передаточной функции замкнутой системы.

Частота Найквиста — в цифровой обработке сигналов частота, равная половине частоты дискретизации. Названа в честь Гарри Найквиста.

Генератор сигналов — устройство, позволяющее производить (генерировать) сигнал определённой природы, имеющий заданные характеристики. Генераторы широко используются для преобразования сигналов, для измерений и в других областях. Состоит из источника и формирователя.

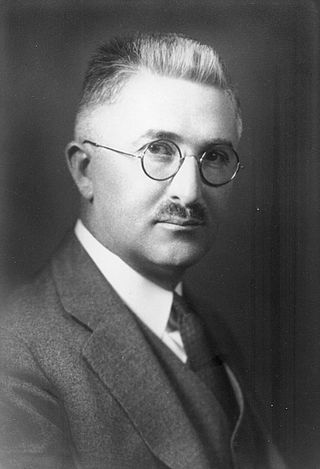

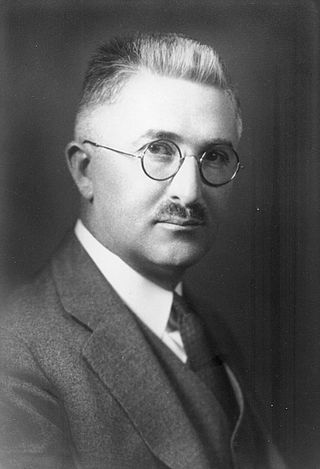

Ральф Винтон Лайон Хартли — американский учёный-электронщик. Он предложил генератор Хартли, преобразование Хартли и сделал вклад в теорию информации, введя в 1928 году логарифмическую меру информации  , которая называется хартлиевским количеством информации или просто мерой Хартли.

, которая называется хартлиевским количеством информации или просто мерой Хартли.

Цифрово́й звук — результат преобразования аналогового сигнала звукового диапазона в цифровой аудиоформат.

Хронология событий, связанных с  теорией информации,

теорией информации, сжатием данных,

сжатием данных,  кодами коррекции ошибок и смежных дисциплин:

кодами коррекции ошибок и смежных дисциплин:

- 1872

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа.

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа. - 1878

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы.

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы. - 1924

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации.

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации. - 1927

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике.

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике. - 1928

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой.

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой. - 1929

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы.

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы. - 1940

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus.

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus. - 1944

— теория информации Клода Шеннона в основном завершена.

— теория информации Клода Шеннона в основном завершена. - 1947

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года.

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года. - 1948

— Клод Шеннон публикует Математическую теорию связи

— Клод Шеннон публикует Математическую теорию связи - 1949

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли.

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли. - 1949

— Рассекречена Теория связи в секретных системах Клода Шеннона.

— Рассекречена Теория связи в секретных системах Клода Шеннона. - 1949

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано.

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано. - 1949

— опубликовано Неравенство Крафта — Макмиллана.

— опубликовано Неравенство Крафта — Макмиллана. - 1949

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения.

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения. - 1950

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения.

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения. - 1951

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера.

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера. - 1951

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь.

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь. - 1953

— опубликован Sardinas–Patterson algorithm.

— опубликован Sardinas–Patterson algorithm. - 1954

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера.

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера. - 1955

— Питер Элиас вводит свёрточные коды.

— Питер Элиас вводит свёрточные коды. - 1957

— Юджин Прандж первый обсуждает циклический избыточный код.

— Юджин Прандж первый обсуждает циклический избыточный код. - 1959

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды).

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды). - 1960

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона.

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона. - 1962

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений.

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений. - 1966

— опубликована статья Дэвида Форнея Concatenated error correction code.

— опубликована статья Дэвида Форнея Concatenated error correction code. - 1967

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов.

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов. - 1968

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году.

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году. - 1968

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод.

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод. - 1972

— опубликована статья о Justesen code.

— опубликована статья о Justesen code. - 1973

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования.

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования. - 1976

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции.

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции. - 1976

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM.

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM. - 1977

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77)

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77) - 1982

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек.

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек. - 1989

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь.

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь. - 1993

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов.

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов. - 1994

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2.

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2. - 1995

— Benjamin Schumacher предложил термин Кубит.

— Benjamin Schumacher предложил термин Кубит. - 1998

— предложен Fountain code.

— предложен Fountain code. - 2001

— описан алгоритм Statistical Lempel–Ziv.

— описан алгоритм Statistical Lempel–Ziv. - 2008

— Erdal Arıkan предложил Полярные коды.

— Erdal Arıkan предложил Полярные коды.

Теорема Шеннона — Хартли в теории информации — применение теоремы кодирования канала с шумом к архетипичному случаю непрерывного временно́го аналогового канала коммуникаций, искажённого гауссовским шумом. Теорема устанавливает шенноновскую ёмкость канала, верхнюю границу максимального количества безошибочных цифровых данных, которое может быть передано по такой связи коммуникации с указанной полосой пропускания в присутствии шумового вмешательства, согласно предположению, что мощность сигнала ограничена, и гауссовский шум характеризуется известной мощностью или спектральной плотностью мощности. Закон назван в честь Клода Шеннона и Ральфа Хартли.

«Математическая теория связи» — статья, опубликованная Клодом Шенноном в 1948 году в реферативном журнале американской телефонной компании «Bell System» и сделавшая его всемирно известным. Содержит в себе большое количество инновационных и плодотворных идей, эта работа инициировала многие научные исследования по всему миру, продолжающиеся по сей день, положив начало развитию методов обработки, передачи и хранения информации.

«Теория связи в секретных системах» — статья американского математика и инженера Клода Шеннона, опубликованная в журнале Bell System Technical Journal в 1949 году.

Шумовая модель коммуникации К. Шеннона — У. Уивера — математическая модель, которая описывает линейную передачу сообщений и рассматривает основные объекты коммуникации. Была предложена в 1949 году Клодом Элвудом Шенноном и Уорреном Уивером.

Симплинг или же сэмплинг обработки сигналов представляет собой преобразование сигнала непрерывного времени в сигнал дискретного времени. Распространенным примером является преобразование звуковой волны в последовательность «сэмплов». Сэмплинг — это значение сигнала в определенный момент времени и / или пространства; это определение отличается от использования в статистике, которое относится к набору таких значений.