Сервер многоточечной конференции — аппаратно-программное устройство, предназначенное для объединения аудио- и видеоконференции в многоточечный режим. Сервер многоточечной конференции обеспечивает связь двух или более абонентов, имеющих стандартное оборудование — H.323- или SIP-терминалы. Наряду с терминалами и шлюзами, MCU может входить в зону сети H.323 и взаимодействовать с привратником.

Кориоли́сов расходоме́р — средство измерения, использующее силу Кориолиса для измерения массового расхода жидкостей, газов. Также данные устройства используются для измерения расхода СУГ.

Рекуррентные нейронные сети — вид нейронных сетей, где связи между элементами образуют направленную последовательность. Благодаря этому появляется возможность обрабатывать серии событий во времени или последовательные пространственные цепочки. В отличие от многослойных перцептронов, рекуррентные сети могут использовать свою внутреннюю память для обработки последовательностей произвольной длины. Поэтому сети RNN применимы в таких задачах, где нечто целостное разбито на части, например: распознавание рукописного текста или распознавание речи. Было предложено много различных архитектурных решений для рекуррентных сетей от простых до сложных. В последнее время наибольшее распространение получили сеть с долговременной и кратковременной памятью (LSTM) и управляемый рекуррентный блок (GRU).

Даббала Раджагопал «Радж» Редди — учёный в области теории вычислительных систем, профессор по информатике и робототехнике при университете Карнеги — Меллон. Награждён в 1994 году премией Тьюринга за достижения в исследовании искусственного интеллекта, в частности экспертных систем.

Метод конечных разностей во временно́й области или метод Йи — численный метод впервые применённый к задачам электродинамики китайско-американским математиком Кейном С. Йи, основанный на дискретизации уравнений Максвелла методом конечных разностей. Поскольку это метод временной области, решения FDTD охватывают широкий диапазон частот за один прогон и учитывают нелинейные свойства материала естественным образом на этапе дискретизации.

Модифицированное дискретное косинус-преобразование (МДКП) является преобразованием Фурье и основывается на дискретном косинусном преобразовании (ДКП-IV). Это преобразование с перекрытием. Оно выполняется на последовательных блоках объемных наборов данных, каждый из последующих блоков перекрывается. Это происходит следующим образом: вторая половина предыдущего блока совпадает с первой половиной следующего. Такое перекрытие, вдобавок к функциям ДКП, делает МДКП особенно полезным для сжатия сигналов тех приложений, где необходимо избежать появления артефактов, которые обычно выходят за границы блоков.

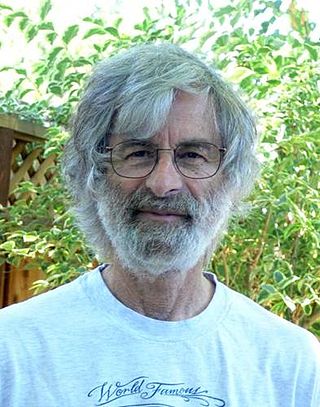

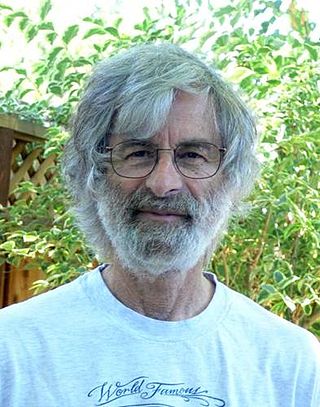

Лоренс Рабинер — инженер AT&T, учёный в области цифровой обработки сигналов и распознавания речи. Член Национальной академии наук США. Занимается исследованиями и преподаёт в Рутгерском и Калифорнийском университетах.

Лесли Лэмпорт — американский учёный в области информатики, первый лауреат премии Дейкстры. Разработчик LaTeX — популярного набора макрорасширений системы компьютерной вёрстки TeX, исследователь теории распределённых систем, темпоральной логики и вопросов синхронизации процессов во взаимодействующих системах. Лауреат Премии Тьюринга 2013 года.

Фредерик Джелинек — учёный в области теории вычислительных систем, один из пионеров обработки естественного языка и автоматического распознавания речи.

Фо́рма волны́ — наглядное представление формы сигнала, такого как волна, распространяющегося в физической среде, или его абстрактное представление.

Глубокое обучение — совокупность методов машинного обучения, основанных на обучении представлениям, а не специализированных алгоритмах под конкретные задачи. Многие методы глубокого обучения были известны ещё в 1980-е годы, но результаты не впечатляли, пока продвижения в теории искусственных нейронных сетей и вычислительные мощности середины 2000-х годов не позволили создавать сложные технологические архитектуры нейронных сетей, обладающие достаточной производительностью и позволяющие решать широкий спектр задач, не поддававшихся эффективному решению ранее, например, в компьютерном зрении, машинном переводе, распознавании речи, причём качество решения во многих случаях теперь сопоставимо, а в некоторых превосходит эффективность человека.

Гео́ргиос Б. Янна́кис — греческий и американский учёный в области информатики, специалист по беспроводным телекоммуникациям, профессор факультета электронной и компьютерной инженерии Миннесотского университета и директор Центра цифровых технологий при этом же университете. Согласно исследованиям транснациональной медиакомпании Thomson Reuters 2015 и 2016 годов, Яннакис входит в число ведущих учёных мира, оказывающих наибольшее влияние на развитие соответствующих отраслей знаний. Имеет h-индекс равный 125 и был процитирован более 60 100 раз.

Франко Препарата — известный специалист в области информатики. Наиболее известен благодаря своей книге по вычислительной геометрии 1985 года, которую написал вместе с Майклом Шеймосом, которая много лет была основным университетским учебником по вычислительной геометрии. Но Препарата также работал во многих других отраслях информатики: его начальная работа была по теории кодирования, а его работа 1981 года по распределенным вычислениям, описывающая компьютерные сети в виде кубическо-связных циклов до сих пор часто цитируется, как и его публикация 1967 года на тему диагностирования ошибок. Его работу 1991 года с Чжоу и Кангом на тему задержек взаимосвязи в VLSI в 1993 отметили «Darlington Best Paper Award» с IEEE Circuits and Systems Society, также внимание медиа привлекла его недавняя работа по вычислительной биологии.

Обучение признакам или обучение представлениям — это набор техник, которые позволяют системе автоматически обнаружить представления, необходимые для выявления признаков или классификации исходных (сырых) данных. Это заменяет ручное конструирование признаков и позволяет машине как изучать признаки, так и использовать их для решения специфичных задач.

Неотрицательное матричное разложение (НМР), а также неотрицательное приближение матрицы, это группа алгоритмов в мультивариантном анализе и линейной алгебре, в которых матрица V разлагается на (обычно) две матрицы W и H, со свойством, что все три матрицы имеют неотрицательные элементы. Эта неотрицательность делает получившиеся матрицы более простыми для исследования. В приложениях, таких как обработка спектрограмм аудиосигнала или данных мускульной активности, неотрицательность свойственна рассматриваемым данным. Поскольку задача в общем случае неразрешима, её обычно численно аппроксимируют.

Ансамблевое обучение — техника машинного обучения, использующая несколько обученных алгоритмов с целью получения лучшей предсказательной эффективности, чем можно было бы получить от каждого алгоритма по отдельности. В отличие от статистического ансамбля в статистической механике, который обычно бесконечен, ансамбль моделей в машинном обучении состоит из конкретного конечного множества альтернативных моделей, но обычно позволяет существовать гораздо более гибким структурам.

Слияние данных является процессом объединения источников данных для получения более согласующейся, точной и полезной информации, чем информация от одного отдельного источника.

Петровский Александр Александрович — советский и белорусский ученый в области вычислительной техники и цифровой обработки сигналов, профессор, доктор технических наук.

ESPRIT — численный метод, позволяющий оценить параметры суммы синусоид на фоне шумов по серии измерений. Является одним из спектральных алгоритмов сверхразрешения, использующих спектральное разложение корреляционной матрицы сигналов.

Координатный спуск — алгоритм оптимизации, который последовательно проводит минимизацию функции вдоль координатных направлений. На каждой итерации, алгоритм определяет координатную переменную или координатный блок посредством правила выбора координат, затем точно или приближённо минимизирует по соответствующей координатной гиперплоскости при фиксировании других координат или координатных блоков. На текущей итерации может быть осуществлён линейный поиск вдоль координатного направления, чтобы найти подходящий размер шага. Координатный спуск может быть применён как в дифференцируемом случае, так и в случае контекста, когда производные не вычисляются.