Информа́тика — наука о методах и процессах сбора, хранения, обработки, передачи, анализа и оценки информации с применением компьютерных технологий, обеспечивающих возможность её использования для принятия решений.

Програ́ммное обеспе́чение (ПО) — программа или множество программ, используемых для управления компьютером.

Бит — единица измерения количества информации. 1 бит информации — символ или сигнал, который может принимать два значения: включено или выключено, да или нет, высокий или низкий, заряженный или незаряженный; в двоичной системе исчисления это 1 (единица) или 0 (ноль). Это минимальное количество информации, которое необходимо для ликвидации минимальной неопределенности.

Информа́ция — сведения независимо от формы их представления.

Шифрова́ние — обратимое преобразование информации в целях сокрытия от неавторизованных лиц с предоставлением в это же время авторизованным пользователям доступа к ней. Главным образом, шифрование служит для соблюдения конфиденциальности передаваемой информации. Важной особенностью любого алгоритма шифрования является использование ключа, который утверждает выбор конкретного преобразования из совокупности возможных для данного алгоритма.

Открытая система:

- Открытая система в физике — система, которая обменивается веществом и энергией с внешним по отношению к системе миром, в отличие от закрытых и изолированных систем, в которые и из которых ни вещество, ни энергия не могут войти или выйти. С понятием изолированной системы тесно связано понятие энтропии.

- Открытая система в информатике — аппаратура и/или программное обеспечение, которое обеспечивает переносимость и совместимость, а часто и их вместе с другими компьютерными системами.

- Открытая система в биологии — организмы, устойчивые лишь при условии непрерывного поступления в них энергии и вещества из окружающей среды.

- Открытая система в теории систем — система, которая непрерывно взаимодействует с её средой. Взаимодействие может принять форму информации, энергии или материальных преобразований на границе с системой.

Энтропи́я — широко используемый в естественных и точных науках термин, обозначающий меру необратимого рассеивания энергии или бесполезности энергии. Для понятия энтропии в данном разделе физики используют название термодинамическая энтропия; термодинамическая энтропия обычно применяется для описания равновесных (обратимых) процессов.

Информацио́нная энтропи́я — мера неопределённости некоторой системы, в частности, непредсказуемость появления какого-либо символа первичного алфавита. В последнем случае при отсутствии информационных потерь энтропия численно равна количеству информации на символ передаваемого сообщения.

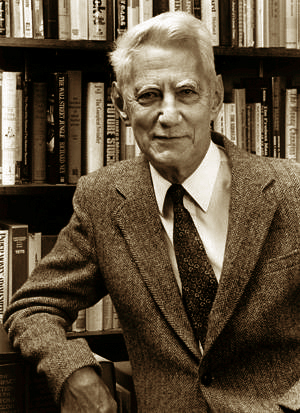

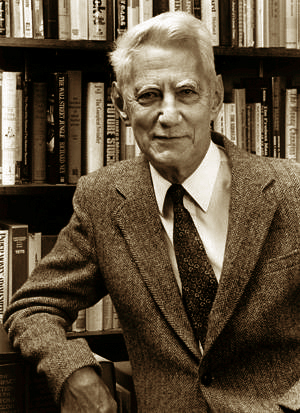

Клод Э́лвуд Ше́ннон — американский инженер, криптоаналитик и математик. Считается «отцом информационного века».

Криптогра́фия — наука о методах обеспечения конфиденциальности, целостности данных, аутентификации, шифрования.

Теория информации — раздел прикладной математики, радиотехники и информатики, относящийся к измерению количества информации, её свойств и устанавливающий предельные соотношения для систем передачи данных. Как и любая математическая теория, теория оперирует математическими моделями, а не реальными физическими объектами. Использует, главным образом, математический аппарат теории вероятностей и математической статистики.

Информацио́нные техноло́гии — процессы, использующие совокупность средств и методов сбора, обработки, накопления и передачи данных для получения информации нового качества о состоянии объекта, процесса, явления, информационного продукта, а также распространения информации и способы осуществления таких процессов и методов.

Негэнтропи́я — философский и физический термин, образованный добавлением отрицательной приставки нег- к понятию энтропия, и обозначающий его противоположность. В самом общем смысле противоположен по смыслу энтропии и означает меру упорядоченности и организованности системы или качество имеющейся в системе энергии. Термин иногда используется в физике и математике для обозначения величины, математически противоположной к величине энтропии.

Хронология событий, связанных с  теорией информации,

теорией информации, сжатием данных,

сжатием данных,  кодами коррекции ошибок и смежных дисциплин:

кодами коррекции ошибок и смежных дисциплин:

- 1872

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа.

— Людвиг Больцман представляет свою H-теорему, а вместе с этим формулу Σpi log pi для энтропии одной частицы газа. - 1878

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы.

— Джозайя Уиллард Гиббс, определяет энтропию Гиббса: вероятности в формуле энтропии теперь взяты как вероятности состояния целой системы. - 1924

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации.

— Гарри Найквист рассуждает о квантификации «Интеллекта» и скорости, на которой это может быть передано системой коммуникации. - 1927

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике.

— Джон фон Нейман определяет фон Неймановскую энтропию, расширяя Гиббсовскую энтропию в квантовой механике. - 1928

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой.

— Ральф Хартли представляет формулу Хартли как логарифм числа возможных сообщений, с информацией, передаваемой, когда приёмник может отличить одну последовательность символов от любой другой. - 1929

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы.

— Лео Силард анализирует демона Максвелла, показывают, как двигатель Szilard может иногда преобразовывать информацию в извлечение полезной работы. - 1940

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus.

— Алан Тьюринг представляет deciban как единицу измерения информации в немецкой машине Энигма с настройками, зашифрованными процессом Banburismus. - 1944

— теория информации Клода Шеннона в основном завершена.

— теория информации Клода Шеннона в основном завершена. - 1947

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года.

— Ричард Хемминг изобретает Код Хемминга для обнаружения ошибок и их исправления, но не публикует их до 1950 года. - 1948

— Клод Шеннон публикует Математическую теорию связи

— Клод Шеннон публикует Математическую теорию связи - 1949

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли.

— Клод Шеннон публикует Передачу Информации в виде шумов, в которой описаны Теорема отсчётов и Теорема Шеннона — Хартли. - 1949

— Рассекречена Теория связи в секретных системах Клода Шеннона.

— Рассекречена Теория связи в секретных системах Клода Шеннона. - 1949

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано.

— Роберт Фано опубликовал отчет, в котором независимо от Клода Шеннона описан Алгоритм Шеннона — Фано. - 1949

— опубликовано Неравенство Крафта — Макмиллана.

— опубликовано Неравенство Крафта — Макмиллана. - 1949

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения.

— Марсель Голей вводит коды Голея для исправления ошибок методом упреждения. - 1950

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения.

— Ричард Хемминг публикует коды Хемминга для исправления ошибок методом упреждения. - 1951

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера.

— Соломон Кульбак и Ричард Лейблер вводят понятие расстояния Кульбака-Лейблера. - 1951

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь.

— Дэвид Хаффман изобретает кодирование Хаффмана, метод нахождения оптимальных префиксных кодов для сжатия данных без потерь. - 1953

— опубликован Sardinas–Patterson algorithm.

— опубликован Sardinas–Patterson algorithm. - 1954

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера.

— Ирвинг Рид и Дэвид E. Мюллер вводит коды Рида-Мюллера. - 1955

— Питер Элиас вводит свёрточные коды.

— Питер Элиас вводит свёрточные коды. - 1957

— Юджин Прандж первый обсуждает циклический избыточный код.

— Юджин Прандж первый обсуждает циклический избыточный код. - 1959

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды).

— Алексис Хоквингем, и самостоятельно в следующем году Радж Чандра Боуз и Двайджендра Камар Рей-Чоудхури, представляют коды Боуза-Чоудхури-Хоквингема (БЧХ-коды). - 1960

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона.

— Ирвинг Рид и Густав Соломон вводят коды Рида-Соломона. - 1962

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений.

— Роберт Галлагер предлагает код с малой плотностью проверок на чётность; их не использовали в течение 30 лет из-за технических ограничений. - 1966

— опубликована статья Дэвида Форнея Concatenated error correction code.

— опубликована статья Дэвида Форнея Concatenated error correction code. - 1967

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов.

— Эндрю Витерби открывает алгоритм Витерби, делающий возможным декодирование свёрточных кодов. - 1968

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году.

— Элвин Берлекэмп изобретает алгоритм Берлекэмпа — Мэсси; его применение к расшифровке БЧХ-кодов и кода Рида-Соломона, указанный Джеймсом Мэсси в последующем году. - 1968

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод.

— Крис Уоллис и Дэвид М. Бутон издают первый из многих докладов о Сообщениях минимальной длины (СМД) — их статистический и индуктивный вывод. - 1972

— опубликована статья о Justesen code.

— опубликована статья о Justesen code. - 1973

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования.

— Дэвид Слепиан и Джек Волф открывают и доказывают Код Слепиана-Вольфа, кодирующего пределы распределённого источника кодирования. - 1976

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции.

— Готфрид Унгербоэк публикует первую статью о Треллис-модуляции. - 1976

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM.

— Йорма Риссанен разрабатывает и позднее патентует арифметическое кодирование для IBM. - 1977

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77)

— Абрахам Лемпель и Яаков Зив разрабатывают алгоритм сжатия Лемпеля-Зива (LZ77) - 1982

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек.

— Готфрид Унгербоэк публикует более подробное описание Треллис-модуляции, что приводит к увеличению скорости аналогового модема старой обычной телефонной службы от 9.6 кбит/сек до 36 кбит/сек. - 1989

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь.

— Фил Кац создаёт .zip формат, включая формат сжатия DEFLATE ; позже это становится наиболее широко используемым алгоритмом сжатия без потерь. - 1993

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов.

— Клод Берроу, Алэйн Главиукс и Punya Thitimajshima вводят понятие Турбо-кодов. - 1994

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2.

— Майкл Барроуз и Дэвид Уилер публикуют теорию преобразования Барроуза-Уилера, которая далее найдет своё применение в bzip2. - 1995

— Benjamin Schumacher предложил термин Кубит.

— Benjamin Schumacher предложил термин Кубит. - 1998

— предложен Fountain code.

— предложен Fountain code. - 2001

— описан алгоритм Statistical Lempel–Ziv.

— описан алгоритм Statistical Lempel–Ziv. - 2008

— Erdal Arıkan предложил Полярные коды.

— Erdal Arıkan предложил Полярные коды.

Энтропия языка — статистическая функция текста на определённом языке либо самого языка, определяющая количество информации на единицу текста.

«Математическая теория связи» — статья, опубликованная Клодом Шенноном в 1948 году в реферативном журнале американской телефонной компании «Bell System» и сделавшая его всемирно известным. Содержит в себе большое количество инновационных и плодотворных идей, эта работа инициировала многие научные исследования по всему миру, продолжающиеся по сей день, положив начало развитию методов обработки, передачи и хранения информации.

Дистрибути́вная сема́нтика — это область лингвистики, которая занимается вычислением степени семантической близости между лингвистическими единицами на основании их распределения (дистрибуции) в больших массивах лингвистических данных.

Преобразова́ние едини́ц — перевод физической величины, выраженной в одной системе единиц, в другую систему, обычно через коэффициент пересчёта.

Локализация компьютерной игры — подготовка программного и аппаратного обеспечения компьютерной игры к продаже в новом регионе или стране. Локализация включает перевод с языка оригинала на иностранный язык, изменение художественных средств игры, создание новых запакованных файлов и справочных руководств, запись новых аудиофайлов, преобразование аппаратного обеспечения, изменение отдельных фрагментов игры согласно культурным особенностям определённого региона, добавление дополнительных участков для перемещения вырезанного контента.

Шумовая модель коммуникации К. Шеннона — У. Уивера — математическая модель, которая описывает линейную передачу сообщений и рассматривает основные объекты коммуникации. Была предложена в 1949 году Клодом Элвудом Шенноном и Уорреном Уивером.